1. 工作概要

- GAT,图注意力神经网络

- 为图中节点赋予不同的权重来关注其邻域特征

- 基于masked self-attentional layer能够并行计算

- 能够推广到inductive任务

2. 模型介绍

-

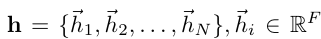

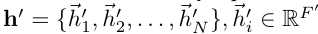

输入:节点特征集合

-

输出:更新后的节点特征集合

-

self-attention机制

-

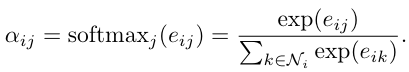

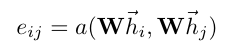

节点间的attention系数计算

-

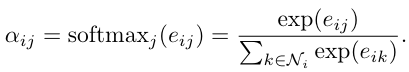

计算与一阶邻居的attention,使用softmax归一化

-

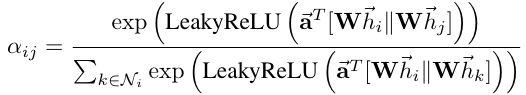

为单层前馈神经网络,使用LeakyReLU进行非线性化

-

-

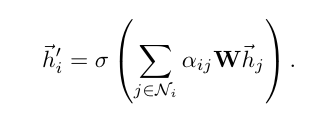

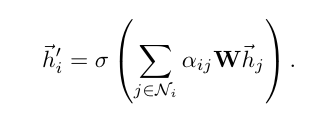

节点特征更新

-

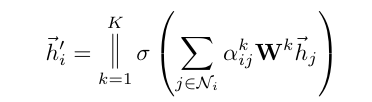

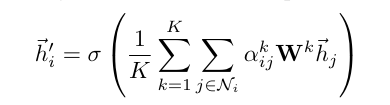

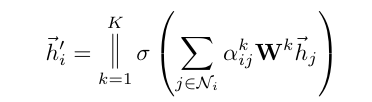

多头注意力:拼接K个独立的注意力机制

-

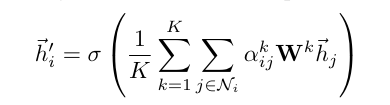

最后一层输出:求K个注意力机制上的均值

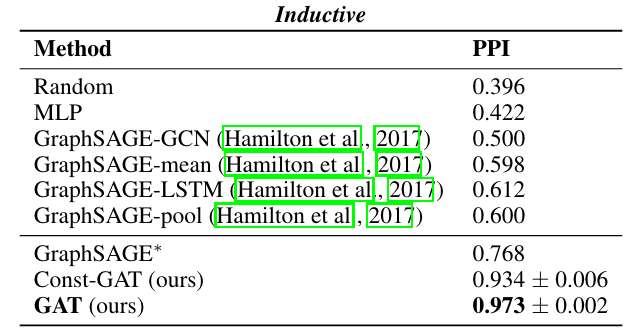

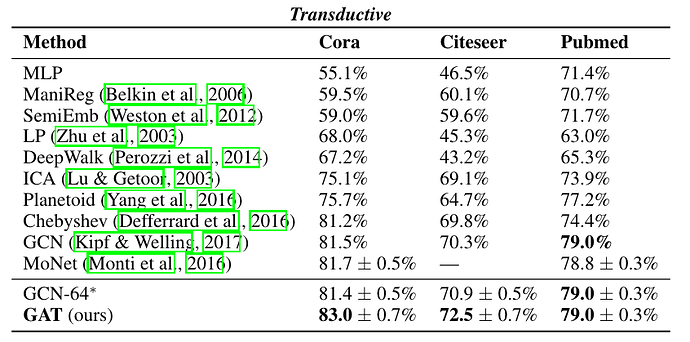

3. 实验结果

-

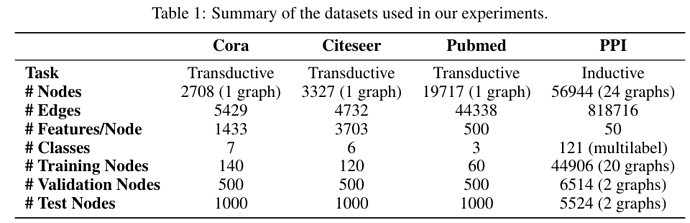

数据集

-

Transductive任务

• Inductive任务