论文链接:Node Feature Extraction by Self-Supervised Multi-scale Neighborhood Prediction | OpenReview

代码仓库:pecos/examples/giant-xrt at mainline · amzn/pecos · GitHub

背景

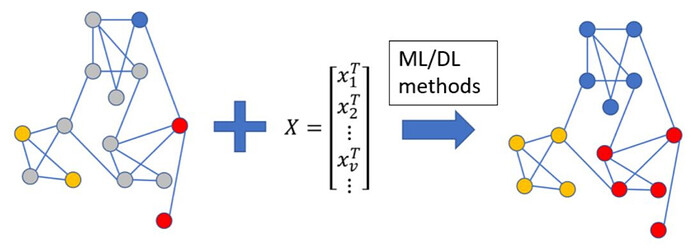

由于大量的实际应用,图上的学习在学习社区中引起了极大的关注。特别是,以数值节点特征和图结构为输入的图神经网络(gnn),已经被证明可以在各种图相关的方面实现最先进的性能。然而,用于从原始数据中提取数值节点特征的方法在标准GNN中仍然是图无关的。

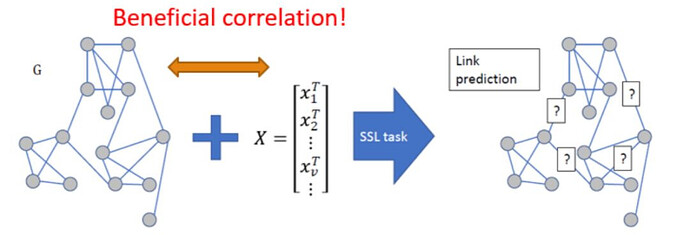

另一方面,最近自监督学习(SSL)于GNN上取得了成功,因为其能改善标签不足的问题而吸引许多研究者投入此方向。利用自监督学习,GNN能生成信息更为丰富的节点嵌入(embedding)或是更好的初始化,进而在下游任务中达到更好的表现。而其主要职官解释为图拓谱 与 节点特征 不仅有有益的相关性,且皆能帮助下游任务。

XMC问题

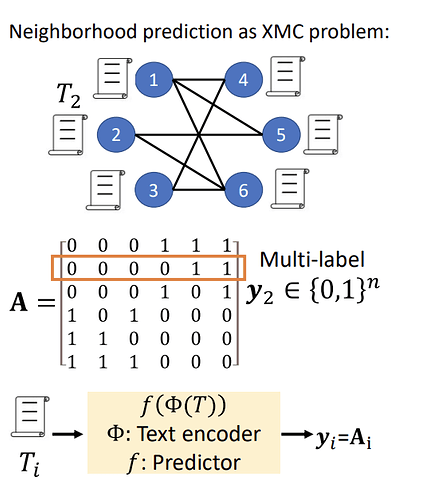

XMC 问题可以简洁地表述如下:给定一个训练集 {Ti, yi}ni=1,其中 Ti ∈ D 是第 i 个输入文本实例 和 yi ∈ {0, 1},L 是来自大量标签的目标多标签。目标是 学习一个函数 f : D ×[L] 7→ R,其中 f(T, l) 捕获输入文本 T 和标签 l。 XMC 问题在许多实际应用中都很重要:例如,在电子商务动态搜索广告中,当试图找到从商品到市场上出价查询的“良好”映射时,就会出现 XMC。在开放域问答中,尝试映射 ques3 时会出现 XMC 问题。

新的自监督任务

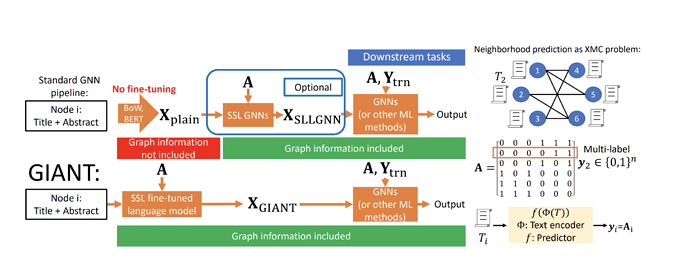

作者的框架采用原始节点属性并生成数字节点具有图结构自监督的特征。将图拓扑信息集成到BERT 等语言模型,作者还提出了一种新的 SSL 任务,称为邻域预测,它适用于同质图和异质图,并在它们之间建立联系邻域预测和极限多标签分类 (XMC) 问题。粗略地说,每个节点的邻域可以使用二进制多标签(指示节点是否为邻居)进行编码,并且BERT 模型通过不断改进预测的邻域进行微调。这种方法使我们不仅可以利用高级求解器解决 XMC 问题,还可以解决与图无关的特征提取,还可以对 XMC 问题进行理论研究和确定其在图形引导 SSL 的上下文中的重要性。

图自监督以及GIANT框架

作者指出了现有GNN训练框架中一个重要却被忽略的问题:如何获取高质量的数值的节点特征。以Amazon co-purchase network 为例,传统做法是利用 与图无关 的 Bag-of-Words (BoW) 或是预训练BERT 得到。如 ogbn-products中,其数值节点特征 便是由BoW 根据原始产品文字信息得到。这种做法是次优的,因为它阻止了充分利用图拓扑和节点属性之间的潜在关联。为了缓解这一问题,作者提出了一种新的自监督学习框架——图信息辅助节点特征提取(GIANT)。GIANT利用了eXtreme多标签分类(XMC)形式化是基于图信息微调语言模型的关键,可扩展到大型数据集。作者同时还提供了一个理论分析,证明了在链路预测中使用XMC,并推动将xr - transformer(一种解决XMC问题的强大方法)集成到GIANT框架中。

实验结果

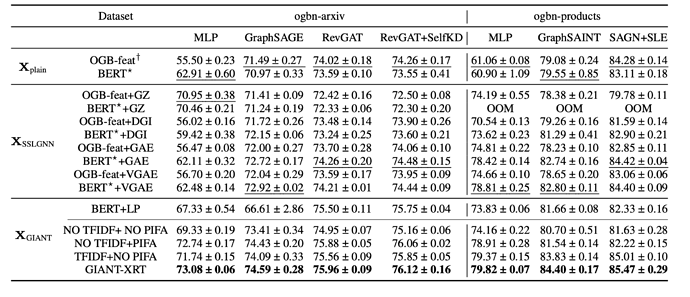

本文中作者专注于节点分类任务,因此选择在三个OGB数据集上进行实验(ogbn-arxiv, ogbn-products, ogbn-papers100M)。除了比较GIANT框架与一般框架之外,也比较了在GIANT框架下利用边预测任务来微调BERT以及XR-Transformer内部组件的消融实验(ablation study)。我们将这些方法产生的数值节点特征送入三类下游任务模型来比较预测表现,分别是MLP(无图拓谱信息), 基本GNN (如GraphSAGE) 以及在OGB榜上的SOTA GNN。可以看到我们的方法(GIANT-XRT)的确对于任何下游模型都有明显的改进,特别是MLP。

总结

-

论文确定标准 GNN 管道中与图无关的特征提取问题并提出一个新的 GIANT 自我监督框架作为该问题的解决方案。

-

论文引入了一种基于图信息提取数值特征的新方法邻域预测的思想。该方法的要点是使用邻域预测

诸如 BERT 之类的语言模型来指导对特征进行微调的过程。与链接预测不同,邻域预测解决了与异质图相关的问题。 -

作者通过在邻域预测和 XMC 问题之间建立相关联系,注意到各个节点的邻域可以由二进制向量编码,二进制向量可以解释为多标签。这允许通过 XR-Transformers 执行邻域预测,专为大规模解决 XMC 问题而设计。

-

我们通过大量实验证明,GIANT 持续大幅提高测试 GNN 在下游任务上的性能。我们还报告了最新的最新技术在 OGB 排行榜上的结果,包括与排名第一的方法相比,准确度的绝对提高大约 1.5%,标准 GNN 提高 3%,多层感知器 (MLP) 提高 14%。更准确地说,作者提高了排名靠前的方法 GAMLP (Zhang et al., 2021b) 的准确性从 68.25% 到 69.67%,SGC (Wu et al., 2019) 从 63.29% 到 66.10%,MLP 从 47.24% 到ogbn-papers100M 数据集上的 61.10%。

-

文章提出了一个新的理论分析,它验证了 XRTransformers 中的关键组件对邻域预测任务的好处。该分析还进一步提高了对 XR-Transformers 和 XMC 问题的理解。

参考资料

如何大幅改善GNN表現?從零(原始數據)開始的節點特徵抽取:ICLR'22 | 如何大幅改善GNN表現?從零(原始數據)開始的節點特徵抽取 - 知乎