第4节作业中,如果这样写的话,也可以跑通,但精度总在68%左右,而且forward方法中没有再使用graph,是比较奇怪的

我感觉preprocessing里面是不是有些问题?

看起来是有点小问题,你可以再仔细调试一下看看

我稍微修改了一下,但是graph好像在forward当中还是没有使用

原论文中有一句这样的话:

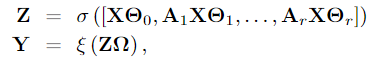

A key observation is that matrix products A_1X,...,A_rX in equation (4) do not depend on the learnable model parameters and can be easily precomputed.

看对应的公式:

$[X,A_1X,…,A_rX]$理论上就在preprocess当中算出来了(即 self.all_x),然后在 train 中经过两层MLP,最后softmax输出,train中是不是不需要 graph 传入的?

如果我们在model外面手动调用了preprocess的话,在forward的时候就不需要graph的信息了。如果外面没有调用的话,我们也需要在forward的时候判断一下是否需要进行preprocess。